Tipps zur Nutzung der Google Search Console

Wenn du deine Website selbst betreust, hast du vielleicht schon den Tipp bekommen, dich bei der Google Search Console anzumelden.

Hast du dich vielleicht noch nicht angemeldet, weil du gar keine Notwendigkeit dafür siehst? Dann verpasst du die Möglichkeit anhand einer Vielzahl von Daten auszuwerten, wie es um deine Website aus Google-Sicht steht. Google liefert hier ein kostenloses Tool, das dir viele wertvolle Hinweise für die Optimierung deiner Website gibt. Du erhältst Insights darüber, wie die Crawler von Google deine Website sehen und welche Seiten im Index sind und vieles mehr. Dazu steht auch ein „Search Console Insights“ Report für Websiteanalysen für Ersteller von Inhalten zu Verfügung – aber dazu später mehr.

Für mich ist die Search Console ein superwertvolles SEO-Tool. Auch bei einem Website-Relaunch ist der Einsatz der GSC unerlässlich.

Die Google Search Console sammelt keine Besucherdaten, sondern bezieht sich auf den Index von Google und die technische Performance deiner Website. Besucherdaten, d.h. detaillierte Informationen darüber, was deine Besucher auf deiner Website machen, über welche Kanäle sie auf die Website gekommen sind oder welches die beliebtesten Seiten auf deiner Website sind, findest du bei Webanalyse-Tools wie Google Analytics.

Hier erhältst du einen Überblick über die wichtigsten Informationen für deine Website-Optimierung, die du in der Search Console finden kannst.

Der Originalartikel stammt aus dem Jahr 2016 und wurde nun aktualisiert.

Die wichtigsten Features der Google Search Console

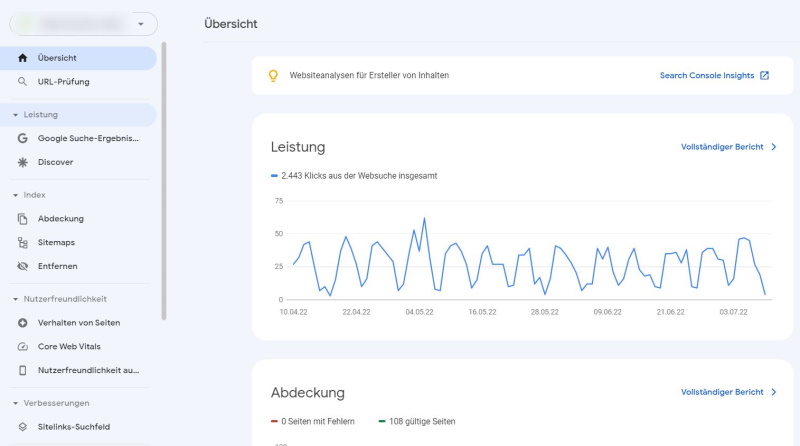

1. Die Übersicht

Im Menü links findest du die diversen Berichte. Die Menüpunkte können bei dir variieren, je nachdem welche Attribute auf deiner Website verwendet werden. Wenn du keine Auszeichnungen für Navigationspfade oder strukturierte Daten hast, dann wird dir natürlich auch kein Bericht dazu angezeigt.

Oben rechts findest Du den Link zur den Search Console Insights.

2. Die Search Console Insights

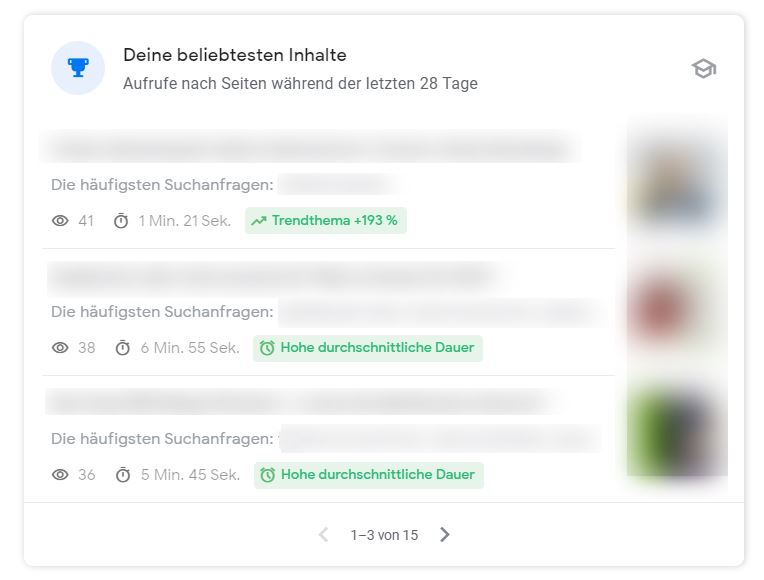

Hier findest du die Seitenaufrufe, die durchschnittliche Dauer der Seitenaufrufe, sowie deine beliebtesten Inhalte, ob sie gerade ein Trendthema sind oder ob Nutzer überdurchschnittlich lange auf dieser Webseite verbracht haben.

Du kommst auf die Search Console Insights, wenn du oben rechts im Überblick auf die Insights klickst. Allerdings funktioniert das nur, wenn die Search Console mit Google Analytics verbunden ist.

Wenn du keine vollständigen Daten siehst, bist du nicht der Inhaber des GSC-Kontos. Jemand anderes hat also für dich das Konto erstellt und zwar als Nutzer angelegt, dir aber die Inhaberschaft nicht übertragen. Wie das funktioniert, kannst du im Artikel über die Nutzerverwaltung in der Google Search Console nachlesen. Schicke ihm den Link, dann kann er dir die Daten freigeben.

Du erhältst auch eine Übersicht welche Suchanfragen die häufigsten waren und wie viele Klicks du über die Google Suche erreicht hast oder was die beliebtesten Inhalte deiner Seite sind. Ein Klick auf das Auge neben einer Seite zeigt dir nochmal detaillierter die Zugriffsquellen und mit welchen Suchbegriffen die Leute auf diese Seite gekommen sind.

Letztendlich ist sind die Search Console Insights, die noch im Betastadium sind, nur eine hübsche Aufbereitung der Daten, garniert mit etwas mehr Infos und liefern im Prinzip nichts, was man nicht auch in der Search Console an sich finden würde. Aber wer sich nicht so gerne in Daten und Tabellen reinfieseln möchte, bekommt hier zumindest einen schnellen Überblick.

Seit Juli 2022 gibt es die Insights auch für Google Analytics 4.

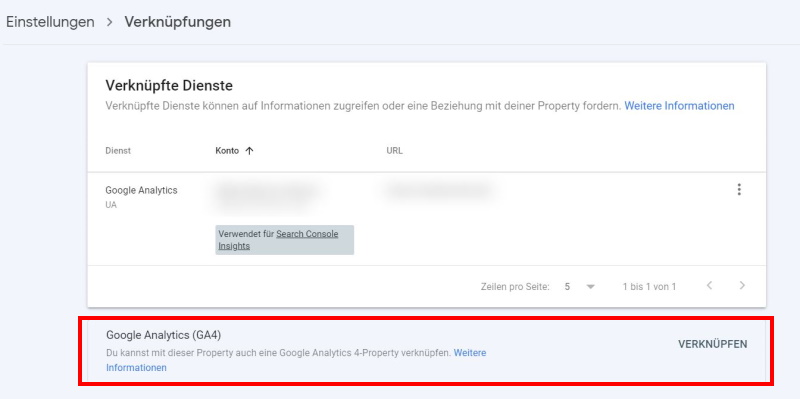

2.1. Die Insights für Google Analytics 4 freischalten

Wenn du bisher ein Universal Google Analytics-Konto hattest und dieses mit der GSC verbunden war, erhältst du die Daten von diesem UA Konto. Wenn du nun bereits eine Google Analytics 4 Property angelegt hast und du lieber hierfür die Daten sehen möchtest, dann gehe im Menü Einstellungen unter Verknüpfung, wo die verknüpften Dienste aufgelistet werden und welche für die Search Console Insights verwendet werden. Das GA4-Konto kannst du nun ganz einfach hinzufügen, in dem du auf Verknüpfung klickst.

Nun ist das GA4-Konto auch verknüpft. Die Insights kommen weiterhin aus der UA-Property. Wenn sie endgültig aus dem GA4-Konto kommen sollen, musst du die Verknüpfung zur UA-Property löschen. Mehr Informationen zum Wechsel von Google Universal auf Google Analytics 4 findest du im Artikel Der Umstieg auf Google Analytics 4.

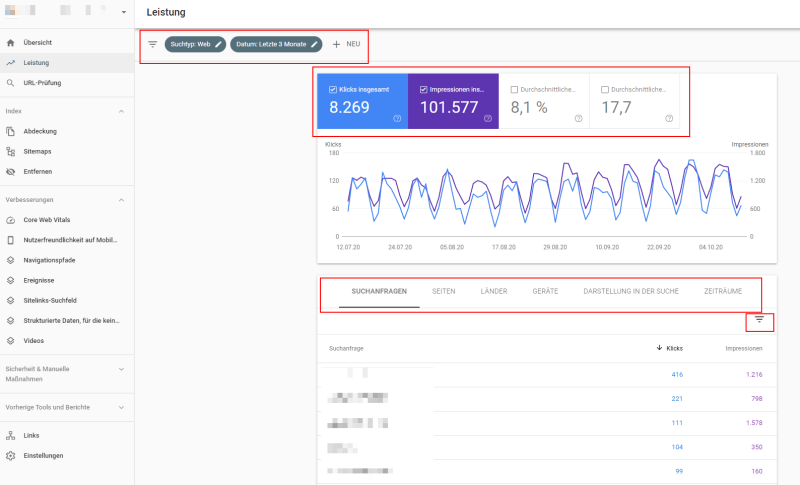

3. Der Bericht „Leistung in der Google-Suche“

Mit welchen Keywords, also Suchanfragen sind Besucher auf die Website gekommen und auf welche Seiten?

Diese Frage beschäftigt jeden Webmaster und im Bericht Leistung erfährst du, bei welchen Suchbegriffen deine Website in den Suchergebnissen gezeigt wurde. Das sind die sogenannten Impressionen. Die Klicks zeigen, wie oft dann tatsächlich auf das Suchergebnis geklickt wurde, daraus ergibt sich die Klickrate. Diese Klickrate, auch CTR oder Click-Through-Rate genannt, ist ein Hinweis für Google, wie interessant und relevant deine Website für Besucher ist. Für dich ist diese Zahl ein nützlicher Hinweis, weil du so z. B. die Darstellung in den Suchergebnissen mit einem noch aussagekräftigeren Seitentitel und Metabeschreibung optimieren könntest.

Der Bericht Leistung kann nach Suchtyp (Web, Bilder, Video) und nach diversen Zeiträumen gefiltert werden sowie nach Suchanfragen, Seiten, Ländern und Geräten. Die Seiten, die hier auftauchen, sind besonders interessant für deine Nutzer, halte sie also möglichst aktuell.

Mit der Filterfunktion rechts kannst du nach Suchanfragen, Klicks, Impressionen, CTR und Position sortieren. So kannst du beispielsweise alle Suchanfragen herausfiltern, die über 5% Klickrate haben, oder Seiten ab einer bestimmten Anzahl von Klicks. Oder die Seiten, die auf mindestens Position 5 stehen etc.

Die Daten werden bis zu 16 Monate gespeichert. Wenn Du länger zurückreichende Daten in Zukunft benötigst, musst Du die Daten regelmäßig exportieren und anderweitig verarbeiten.

Die Abfragefilter können genutzt werden, indem man auf „neu“ klickt:

Klickt man beispielsweise auf eine bestimmte Suchanfrage und danach auf Seiten, erhält man eine Liste der Seiten, die für dieses Keyword potenziell ranken können. Das ist eine wichtige Information für SEO, denn möglicherweise gibt es mehrere Seiten, die miteinander konkurrieren. Dann würde nicht unbedingt die URL in den Suchergebnissen gezeigt, die wichtiger ist. Gerade bei Blogs passiert es häufig, dass man mehrfach über das gleiche Thema schreibt. Dann wäre es empfehlenswert die besser positionierte Seite zu behalten und aufzupolieren. Die schlechtere Seite kann dann auf diese aktualisierte Seite umgeleitet werden.

Umgekehrt kann man unter Seiten auch eine bestimmte Seite anklicken und geht danach auf Suchanfragen. Dann erhältst du eine Liste der Keywords mit denen diese Seite rankt. Vielleicht optimierst du dann nochmal den Seitentitel, weil du hier einen besseren Begriff findest? Der Bericht Leistung ist auch ideal, um Hinweise für mögliche Themen und Texte für deine Website zu erhalten, die auf deiner Website noch nicht abgedeckt sind.

Weitere Tipps zur Nutzung findest Du in meinem Beitrag zum OMT 2020 unter 3.3. Google Search Console Deep Dive von Stephan Czysch.

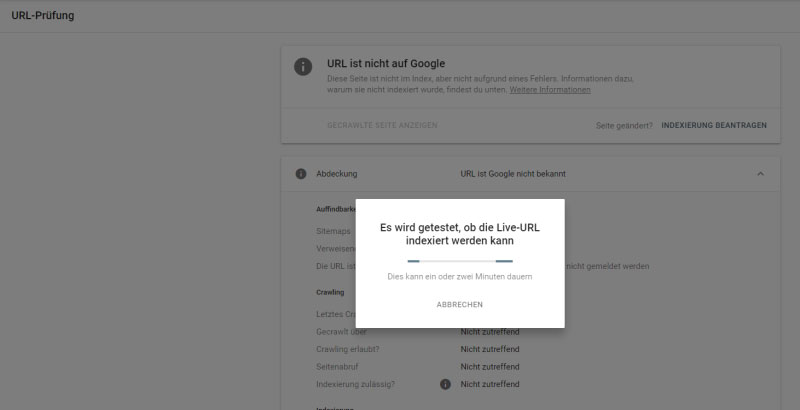

4. URL-Prüfung

Hier kann überprüft werden, ob eine URL indexiert wurde und gefunden werden kann.

Wenn es Fehler gibt, werden diese natürlich ebenfalls angezeigt. Diese Informationen beziehen sich immer auf die indexierte Version der URL. Wenn also zwischenzeitlich Änderungen vorgenommen wurden, dann sind diese möglicherweise noch nicht berücksichtigt. Ist die URL noch nicht auf Google, dann kannst Du die Indexierung beantragen.

Du kannst auch in der Google Suche den Befehl: site:https//deine-domain.de eingeben, um die Seiten anzusehen, die sich im Index befinden und welche Google als wichtig erachtet.

5. Der Bericht Abdeckung

Unter Abdeckung findet man Informationen darüber wie viele gültige Seiten es gibt, wie viele ausgeschlossen wurden und wo es möglicherweise Probleme gibt. Ein Klick auf die Felder zeigt dann die betroffenen Seiten. Hier sollte man überprüfen, ob alles seine Richtigkeit hat.

Klickt man auf eine einzelne URL, erscheint rechts ein weiteres Menü in dem sich die Seitendetails befinden, und wo man nachsehen kann, ob die Seite z. B. aus Versehen in der robots.txt blockiert wurde. Außerdem kann man die Funktion „URL-Prüfung“ nutzen, um zu sehen, ob Google die Seite richtig dargestellt wird. Laut Google benötigst du die robots.txt-Datei nur, wenn deine Website Inhalte aufweist, die nicht von Google oder anderen Suchmaschinen indexiert werden sollen. Wenn Google deine gesamte Website indexieren darf, benötigst du keine robots.txt-Datei. Sinnvoll ist aber das Ausschließen der Anmeldeseiten zu deinem jeweiligen Backend. Bei WordPress ist das schon automatisch eingerichtet, außerdem gibt es Plugins mit denen sich die robots.txt editieren lässt.

Was genau die robots.txt ist, erfährst du im umfangreichen Guide zur robots.txt.

Es ist gerade bei sehr großen Websites wichtig Google nicht alle Seiten der Website zu zeigen. Wenn es viele URLs gibt, die nicht relevant sind, beispielsweise URLs, die durch Filterkombinationen vor allem bei Onlineshops entstehen, gibt es sehr viele URL-Kombinationen wie im nächsten Screenshot gezeigt. Trotzdem solltest du hier überprüfen, ob auch die richtigen URLs vom Index ausgeschlossen wurden.

In diesem Bericht fasst Google die URLs zusammen, die zwar in der XML-Sitemap aufgelistet wurden und an Google gesendet wurden, die aber aus bestimmten Gründen nicht indexiert werden können. Deshalb sollte die XML-Sitemap immer nur die URLs enthalten, die auch wirklich an Google übergeben werden sollen. Wenn du beispielsweise in der XML-Sitemap URLs angibst und diese über die robot.txt aus Versehen wieder ausschließt, erscheint dementsprechend eine Fehlermeldung.

Bei den gültigen Seiten erhält man eine Auflistung der URLs bei denen alles ok ist. „Gesendet und indexiert“ bedeutet, dass die URL in der Sitemap vorhanden ist und in den Index aufgenommen wurde. „Indexiert, nicht in Sitemap gesendet“ weist darauf hin, dass Google hier Seiten findet, die potenziell indexiert werden, die aber noch in der Sitemap aufgelistet werden sollen.

Bei den ausgeschlossenen Seiten findet man alle URLs, die hoffentlich berechtigterweise vom Index ausgeschlossen wurden. Die Gründe dafür sollte man sich allerdings genau ansehen, denn oft genug passieren hier unabsichtlich Fehler. Wenn die Fehlerbehebung abgeschlossen ist, kann man alles nochmal überprüfen lassen. Es ist übrigens auch möglich den Bericht zu teilen und gleich dem Programmierer zuzuschicken.

Sehr interessant ist auch die Angabe „Google hat eine andere Seite als der Nutzer als kanonische Seite bestimmt“. Hier erkennt Google, dass mehrere URLs als „kanonische URL“ gekennzeichnet wurden. Dies ist die ursprüngliche URL, die im Index von Google landen soll. Weitere URLs mit sehr ähnlichem Inhalt werden von Google nicht oder nicht sehr häufig in den Suchergebnissen gezeigt. Sie bieten auch meist keinen weiteren Mehrwert für die Nutzer und man sollte wie oben erwähnt versuchen, solche Seiten mit sehr ähnlichem Thema entweder zusammenzufassen oder die weniger wertvolle Seite auf die relevantere umzuleiten.

6. Sitemaps

Die Sitemap ist eine XML-Datei, die Google das Crawlen deiner Website erleichtert, eine Art Inhaltsverzeichnis. Unter dem Menüpunkt Sitemap kannst du sie ganz einfach hinzufügen. Google selbst empfiehlt das Einreichen der Sitemap, damit die Website schneller durchforstet werden kann und die wirklich wichtigen Seiten in den Index kommen. Siehe dir diese Sitemap vor dem Hochladen genau an. Oft werden nämlich von den Content-Management-Systemen alle Seiten in die Sitemap übernommen, auch wenn diese gar nicht indexiert werden sollen.

Achte hier darauf, dass es keine Fehlermeldungen gibt. Häufige Fehler sind beispielsweise das falsche Format (es muss XML sein) oder es werden Seiten eingereicht, die gar nicht indexiert werden sollen. Oder man verschreibt sich beim Dateinamen (alles schon vorgekommen ;)).

Die Sitemap kann man mit einem Plugin für WordPress erstellen lassen. Empfehlenswert ist es ein SEO-Plugin zu verwenden, da die ausgeschlossenen Seiten dann in keinem Fall aus Versehen in der XML-Sitemap landen. Lies in diesem Artikel wie du in WordPress mit dem SEO-Plugin von Yoast die Sitemap erstellst.

Du kannst auch einzelne Sitemaps einreichen, z.B. für Beiträge, für Seiten, für Bilder etc. Hauptsache du reichst keine Seiten ein, die mit dem no-index-Tag vom Index ausgeschlossen wurden oder in der robots.txt gesperrt wurden.

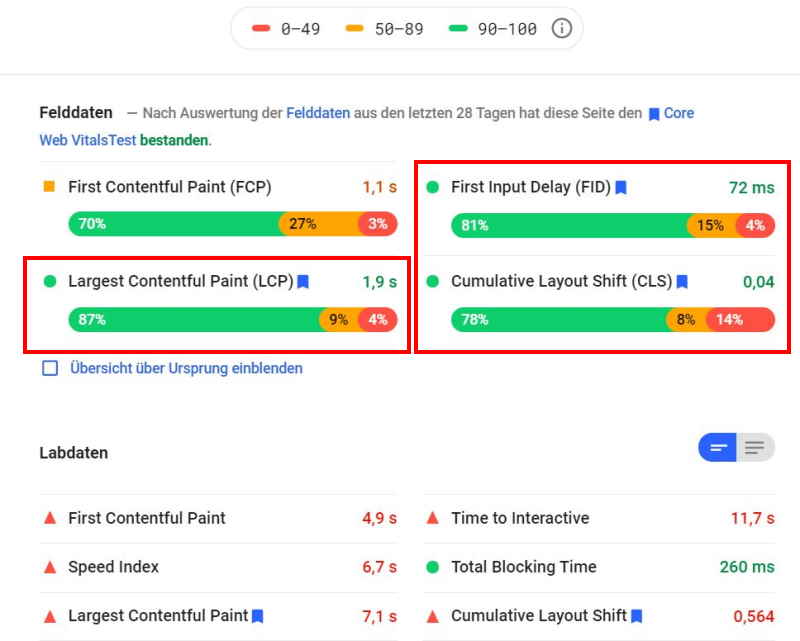

7. Core Web Vitals

Google hat einen neuen Rankingfaktor angekündigt, nämlich die Page Experience mit momentan drei verschiedenen Messwerten. Hier geht es v.a. um die technische Performance der Website.

Largest Contentful Paint (LCP)

Diese Messwert misst die Dauer des Ladevorgangs, bis die Hauptinhalte einer Seite geladen sind. Hier sollten Werte unter 2,5 Sekunden angestrebt werden.

First Input Delay (FID)

Diese Kennzahl misst die Zeit, die vergeht, wenn ein Nutzer auf der Seite ein Element anklickt bis zu dem Zeitpunkt an dem der Browser darauf reagiert.

Cumulative Layout Shift (CLS)

Diese Kennzahl misst die visuelle Stabilität der Seite, d.h. ob sich das Layout der Seite während der Seite verändert, z.B. durch einen Werbe- oder Cookie-Banner oder nachgeladene Elemente.

Diesen Messwerten können sich in Zukunft noch weitere hinzugefügt werden.

Deine Website kann natürlich immer noch auch mit nicht so idealen Werten gut ranken, wenn der Inhalt exzellent ist. Wenn es allerdings eine andere Website gibt, die inhaltlich sehr ähnlich zu Deiner Website ist, ist es möglich, dass diese dann besser rankt, weil das Nutzererlebnis von Google besser eingeschätzt wird. Und von den Nutzern natürlich auch. Denn hier geht es vor allem darum, ob die Ladezeiten gut sind, ob es keine nervigen Pop-ups/Interstitials gibt, ob die Seite mobiloptimiert ist, verschlüsselt ist (HTTPS) etc. Der Hintergrund, warum Google so extrem Wert auf ein schnelles Laden der Webseiten legt, sind natürlich auch durchaus wirtschaftliche Gründe. Je besser die Performance der Website, umso weniger Kosten entstehen bei Google in den Datencentern.

Mit den Page Speed Insights oder auch mit dem Chrome Lighthouse-Plugin kannst du einzelne URLs testen. Hier wurde nur eine einzelne URL getestet, die Probleme hat. Die Page Speed Insights listen genau auf, welche das sind und welche Maßnahmen ergriffen werden können. In WordPress sind das oft lahme Plugins, fehlendes Caching, überfrachtete Themes etc. Oder es wurden zu große Bilddateien hochgeladen.

Eine ausführliche Beschreibung der Messwerte FCP, FID, LCP und CLS findest Du bei Sistrix.

Ein Anmerkung: Die Optimierung der Website betreffend diese drei Messwerte ist wirklich sehr komplex und Du solltest in jedem Fall einen ExpertIn hinzuziehen.

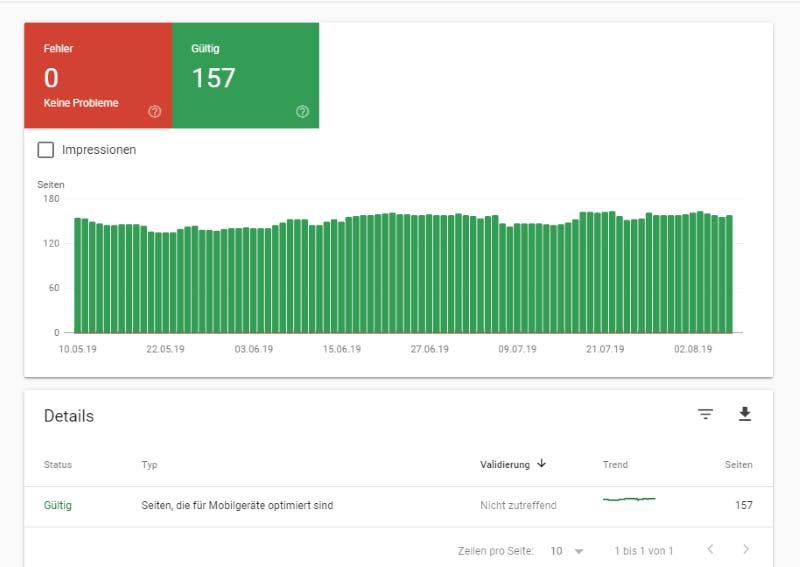

8. Nutzerfreundlichkeit auf Mobilgeräten

Der Unterpunkt „Nutzerfreundlichkeit auf Mobilgeräten“ weist auf eventuelle Probleme mit der Darstellung auf Mobilgeräten hin. Es gibt auch ein Test-Tool von Google mit dem du deine Websiste auf ihre Nutzerfreundlichkeit hin testen kannst und etwas detaillierte Informationen erhältst.

https://search.google.com/test/mobile-friendly

Im Idealfall sieht das Ganze natürlich so aus ;):

Die Optimierung für mobile Geräte ist besonders wichtig, da Google diese Version der Website zur Indexierung heranzieht (Mobile First Indexing). Dabei geht es um die Erfassung von Inhalten, aber nicht um das Ranking. Desktop only-Websites werden natürlich weiterhin in den Suchergebnissen zu finden sein. Die meisten Websites dürften mobil-optimiert sein, also ein responsives Design haben, das auf allen Websites gut aussieht. Wer das noch nicht erledigt hat, sollte das schleunigst dafür sorgen, dass die Website auch mobil gut dasteht.

9. Welche Links verweisen auf die Website?

Unter „Links“ findest du heraus, welche Links zu deiner Website verweisen. Diese „externen Links“ oder Backlinks sind für Google ein wichtiges Signal, wie interessant deine Website für andere Nutzer ist. Für die Suchmaschinenoptimierung ist es unerlässlich sich mit dem Thema Linkbuilding zu beschäftigen. Und das heißt nicht, dass man sich in Hunderte Webkataloge einträgt oder Links kauft ;).

Diese Liste erhebt keinerlei Anspruch auf Vollständigkeit und ist sicherlich kein Ersatz für ein professionelles Backlink-Tools. Aber für einen ersten Überblick ist sie schon mal ganz interessant.

Auch die interne Verlinkung (siehe Artikel SEO mit der internen Verlinkung) ist eine sinnvolle und wichtige SEO-Maßnahme. In diesem Bericht erhältst du eine Übersicht über die Links, die innerhalb deiner Website gesetzt wurden. Verweise nicht zu oft auf eher unwichtige Seiten, die ja auch in der Navigation zu finden sind. Denn damit stärkst Du diese Seite unnötigerweise. Umgekehrt kannst du Seiten stärken, die wichtig sind, indem Du von anderen Seiten auf sie verlinkst.

Dieser Bericht ist nicht besonders aussagekräftig, denn er listet einfach nur die Anzahl der am häufigsten intern verlinkten Seiten auf. Hier gibt es andere Tools, die besser aufzeigen, welche Seiten mit welchen anderen Seiten durch Verlinkung miteinander verbunden sind, wie beispielsweise das Tool Screaming Frog.

10. Die Inhaberschaft der Website in der Search Console bestätigen und mit Google Analytics verknüpfen

Um die Verifizierung der Website vorzunehmen, muss eine von Google generierte HTML-Datei beispielsweise über ein FTP-Programm wie Filezilla in das root-Verzeichnis auf den Server hochgeladen werden. Alternativ kann ein DNS-Eintrag vorgenommen werden.

Google hat Webmastern im Laufe der Zeit immer mehr Informationen darüber weggenommen, mit welchen Suchanfragen bzw. Keywords die Nutzer auf deine Website kommen. Das macht es bezüglich SEO immer schwerer herauszufinden, für welche Keywords man seine Seiten optimieren sollte. Damit du auch in Google Analytics die Daten der Search Console und die Keywords einsehen kannst, ist es sinnvoll die Search Console mit Google Analytics zu verbinden. Kombiniert mit den Metriken von Google Analytics können so weitere Auswertungen vorgenommen werden.

11. HTTP und HTTPS-Seiten in der Google Search Console

Seiten, die unter dem Internet-Protokoll HTTP laufen und solche, die ein SSL-Zertifikat haben und somit mit HTTPS laufen, sind für Google zwei verschiedene Websites. Dies bedeutet, dass wenn du bereits mit deiner HTTP-Seite in der Search Console angemeldet warst, du nun eine neue Property anlegen musst mit HTTPS. Du brauchst die HTTP-Seite nicht löschen und kannst beide in deinem Search-Console-Konto haben. Was du sonst noch beachten musst in der Search Console und in Google Analytics, wenn du die Website von HTTP auf HTTPS umstellst, habe ich in diesem Artikel zusammengefasst: https://tusche-online.de/die-search-console-anpassen-nach-umstellung-auf-https/

12. Fazit

Die Google Search Console ist ein unerlässliches Tool, um zu erfahren, wie Google die Website sieht, mit welchen Suchbegriffen Nutzer auf die Website kommen und ob die Seiten der Website überhaupt von Google indexiert werden. Natürlich gibt es viele andere kostenfreie und kostenpflichtige SEO-Tools, die detailliertere Berichte zu bestimmten Themen liefern, v.a. wenn die Website viele tausend Seiten hat. Aber trotzdem bietet die Search Console sehr interessante Einblicke und man sollte sie in jedem Fall nutzen.

Endlich richtig mit SEO loslegen und den SEO-Workshop buchen

Im SEO-Workshop besprechen wir deine individuelle SEO-Strategie und die richtigen SEO-Maßnahmen für die deine Website und klären alle deine Fragen bezüglich SEO.

Mehr zum SEO-Workshop erfahren!

Impulsvortrag in der virtuellen Kaffeeküche vom 11.02.2021

Hier findest Du die Folien vom Google Search Console Vortrag (PDF), den ich in der virtuellen Kaffeeküche, einem wöchentlich stattfindenden Barcamp, organisiert von WordPress-Expertin Marjeta Prah-Moses, gehalten habe.

[…] Analytics-für-einsteiger.de […]

Vielen herzlichen Dank. Mir als Neuling in diesem Bereich hat das schon etwas weiter geholfen.

Ich danke Ihnen für den interessanten Beitrag. Die Google Search Console ist wirklich ein super Tool und zudem noch kostenlos. Jeder der SEO betreibt sollte mal einen Blick drauf wagen.

Mit besten Grüßen,

Jana

Sehr interessanter Artikel!

Bin da noch relativ neu, aber schon einiges durch Ihre Beiträge gelernt!

Freut mich, wenn der Artikel nützlich ist 🙂

Hallo liebe Cathrin,

ich stehe gerade voll auf dem Schlauch. Ich habe meinen Blog bereits bei der Google Search Console eingereicht. Jetzt bin ich aber damit von blogger.com zu Word Press umgezogen und würde dort gerne meinen Verifizierungs-Code von der Google Search Console eintragen. Wo finde ich den noch mal?

Danke für Deine Antwort!

Valery

Liebe Valery,

wenn sich beim Umzug der Domainname geändert hat, muss man in der Search Console auch eine neue Property (Website) anmelden. Wo genau man den Verifizierungscode bei wordpress.com eingibt, weiß ich leider nicht genau. Wenn du WordPress nutzt und die Website bei einem anderen Provider selbst gehostet wird, dann gibt es diverse Verifizierungsmöglichkeiten (siehe in der Search Console).

Wenn sich der Domainname nicht geändert hat, dann braucht man auch nichts neu verifizieren.

Ich hoffe das hilft dir jetzt erst einmal.

Viele Grüße,

Cathrin

Hallo Valery, welchen Website-Anbieter verwendest du? Bei Wix.com und WordPress geht das ganz einfach – am Besten Youtube Tutorial verwenden! liebe Grüße

Daniel

Hallo,

schöner Artikel. Ich finde die Google Search Console ist eine nützliche Alternative zu teuren Programmen 🙂

Zwar werden die Links dort.nicht sofort aufgeführt und nicht vollständig. Aber es ist ein guter Anhaltspunkt um die eigenen Seiten zu beobachten, insbesondere zum organischen Traffic und den Platzierungen in den SERPs.

LG

Ronny

Vielen Dank für diesen ausführlichen sehr erhellenden Beitrag.

Jetzt wird einiges klar. 🙂

Ich danke Ihnen für den interessanten Artikel. Für die Suchmaschinenoptimierung ist dieses Tool wirklich sehr praktisch. Ich nutze es sehr häufig.

Mit besten Grüßen,

Daniel

Liebe Cathrin, dank deiner Hilfe kenne ich mich nun auch etwas besser aus in der neuen Search Console. Die ganzen Tools sind doch etwas schwierig zu verstehen ohne Hilfe. Danke, liebe Grüße Daniel